芯片资讯

- 发布日期:2024-01-05 13:05 点击次数:181

导读

ChatGPT是由OpenAI公司开发的人工智能聊天机器人程序,于2022年11月发布,达到1亿用户量用时仅2个月。ChatGPT是基于GPT-3.5微调得到的新版本模型,能够借助人类反馈的强化学习(RLHF)技术来指导模型训练,实现模型输出与人类预期的需求,使对话内容更加人性化和富有逻辑性。

01.ChatGPT激起AI浪潮

1.1 AI创新浪潮兴起,多模态赋能下游行业

ChatGPT是生成式人工智能技术(AIGC)的一种,与传统的决策/分析式AI相比,生成式AI并非通过简单分析已有数据来进行分析与决策,而是在学习归纳已有数据后进行演技创造,基于历史进行模仿式、缝合式创作,生成全新的内容。AIGC的应用非常广泛,包括自然语言生成、图像生成、视频生成、音乐生成、艺术创作等领域。

AIGC产业链主要分为上游算力硬件层、中游数据/算法软件层和下游行业应用层。硬件层依靠高性能AI芯片、服务器和数据中心为AIGC模型的训练提供算力支持,是承载行业发展的基础设施;数据/算法层软件层主要负责AI数据的采集、清洗、标注及模型的开发与训练,多方厂商入局自然语言处理、计算机视觉、多模态模型等领域;行业应用层目前主要涉及搜索、对话、推荐等场景,未来有望在多个行业呈现井喷式革新。

资料来源:甲子光年,中泰证券研究所

多模态大模型有望成为AI主流,赋能下游行业智能升级。生成式AI主要依赖于人工智能大模型,如Transformer、BERT、GPT系列等。这些模型通常包含数十亿至数万亿个参数,需要庞大的数据集进行训练,致使AI算力的需求也呈现出指数级的增长。多模态是一种全新的交互、生成模式,集合了图像、语音、文本等方式,因其可以结合多种数据类型和模态的学习,将有望彻底改变我们与机器互动的方式,快速占据人工智能主导地位。我们认为多模态大模型长期来看不仅可以从成本端降本增效,需求端也将通过快速渗透推广为下游行业带来持续增长需求,从而快速推动下游行业智慧化应用升级。

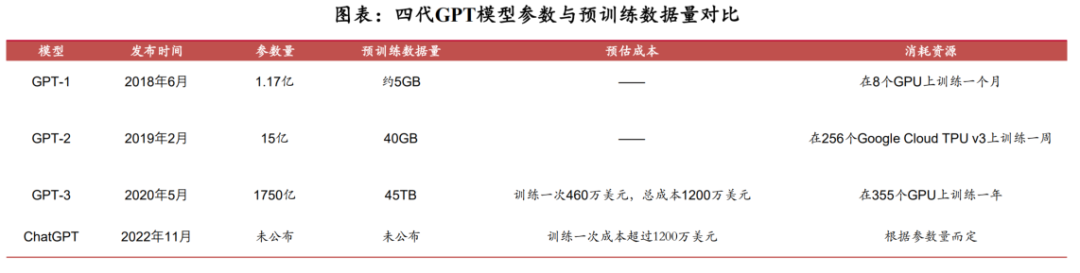

从GPT-1到ChatGPT,模型参数与训练数据量不断增加,所需算力资源不断提升:

GPT-1:最早的GPT模型之一,包含了1.17亿个参数,预训练数据量约为5GB。

GPT-2:参数数量达到了1.5亿个,预训练数据量达40GB。

GPT-3:是目前为止最大的语言模型之一,包含了1750亿个参数,预训练数据量为45TB。

ChatGPT:基于GPT-3模型的变种之一,参数量预计与GPT-3相近。

资料来源:OpenAI官网,中泰证券研究所

多模态模型是实现人工智能应用的关键。3月14日OpenAI发布GPT-4多模态大模型,拥有1)强大的识图能力;2)文字输入限制提升至2.5万字;3)回答准确性显著提高;4)能够生成歌词、创意文本、实现风格变化。在各种专业和学术基准上,GPT-4已具备与人类水平相当表现。如在模拟律师考试中,其分数在应试者前10%,相比下GPT-3.5在倒数10%左右。多模态大模型在整体复杂度及交互性上已有较大提升,模型升级有望加速细分垂直应用成熟,赋能下游智慧化升级,带动需求快速增长。

AIGC下游市场渗透率低,增长空间广阔。根据Gartner数据,目前由人工智能生成的数据占所有数据的1%以下,预计2023年将有20%的内容被生成式AI所创建,2025年人工智能生成数据占比将达到10%。根据前瞻产业研究院数据,2025年中国生成式商业AI应用规模将达2070亿元,CAGR(2020-2025)为84.06%。

1.2 算力芯片迎来产业机遇

AI人工智能的发展主要依赖两个领域的创新和演进:一是模仿人脑建立起来的数学模型和算法,其次是半导体集成电路AI芯片。AI的发展一直伴随着半导体芯片的演进过程,20世纪90年代,贝尔实验室的杨立昆(Yann LeCun)等人一起开发了可以通过训练来识别手写邮政编码的神经网络,但在那个时期,训练一个深度学习卷积神经网络(Convolutional Neural Network,CNN)需要3天的时间,因此无法实际使用,而硬件计算能力的不足,也导致了当时AI科技泡沫的破灭。

AI芯片是AI发展的底层基石。英伟达早在1999年就发明出GPU,但直到2009年才由斯坦福大学发表论文介绍了如何利用现代GPU远超过多核CPU的计算能力(超过70倍),把AI训练时间从几周缩短到了几小时。算力、模型、数据一直是AI发展的三大要素,而AI芯片所代表的算力则是人工智能的底层基石。

算力硬件层是构成AIGC产业的核心底座,主要包括AI芯片、AI服务器和数据中心。

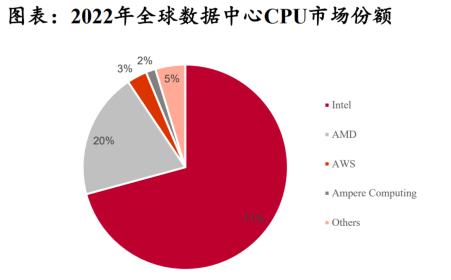

AI芯片是算力硬件层的基石。AI芯片主要分为CPU、GPU、FPGA和ASIC四类,CPU是AI计算的基础,GPU、FPGA、ASIC作为加速芯片协助CPU进行大规模计算。目前AI芯片主要被国际厂商垄断,根据Counterpoint、IDC数据,Intel和AMD共计占2022年全球数据中心CPU市场收入的92.45%,Nvidia占2021年中国加速卡市场份额的80%以上。

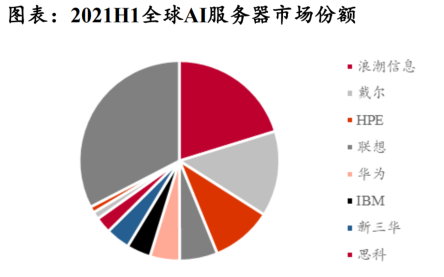

AI服务器是AI芯片的系统集成。AI服务器采用CPU+加速芯片的架构形式,在进行模型的训练和推断时会更具有效率优势。与国外AI芯片厂商的垄断局面不同,中国AI服务器水平位于世界前列。据IDC数据,在2021H1全球AI服务器市场竞争格局中,浪潮信息以20.2%的份额排名第一,联想和华为分别以6.1%和4.8%的份额位列第四、五名。

数据中心的计算服务是承接AI算力需求的直接形式。AIGC的模型训练是通常是通过云计算服务完成的,其本质是AIGC模型厂商借助IDC的算力资源,在云端实现模型的训练。目前国内的数据中心厂商主要包括三大运营商、华为、联想、中科曙光等,提供云计算的厂商主要有阿里、腾讯等互联网企业。

资料来源:智通财经,Counterpoint,IDC,中泰证券研究所

ChatGPT单次训练所需算力约27.5PFlop/s-day,单颗NVIDIAV100需计算220天。

根据OpenAI数据,GPT-3XL参数规模为13.2亿,训练所需算力为27.5PFlop/s-day。由于ChatGPT是在13亿参数的InstructGPT基础上微调而来,参数量与GPT-3XL接近,因此预计ChatGPT训练所需算力约为27.5PFlop/s-day。以NVIDIAV100芯片为例,一颗NVLink版本V100芯片的深度学习算力为125TFlops,则ChatGPT模型的训练至少需要1颗V100芯片计算220天才能完成。

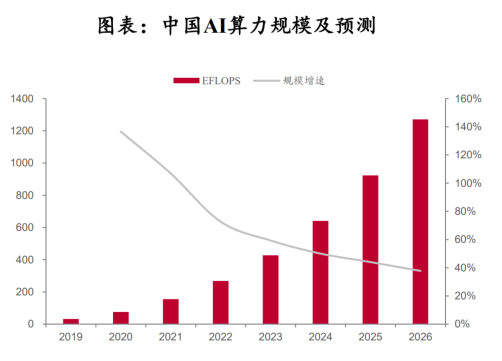

随着模型参数的不断增加,模型训练所需算力将进一步提升,将进一步拉动对算力芯片的需求。根据OpenAI数据,随着GPT-3系列模型参数规模由1.25亿增加至1746亿,训练所需算力从2.6PFlop/s-day上升至3640PFlop/s-day,规模参数(1396.8倍)与算力需求(1400倍)呈同比例增长。

02.芯片是ChatGPT底层土壤

2.1 AI芯片有望率先受益,CPU+XPU异构形式成为主流

机器学习主要包括训练(training)和推断(inference)两个步骤,通常需要不同类型的AI芯片来执行。训练是指通过大数据训练出一个复杂的神经网络模型,通过大量标记过的数据来训练相应的系统,使其能够适应特定的功能;推理是指利用训练好的模型,使用新数据推理出各种结论。

训练芯片:通过大量的数据输入,构建复杂的深度神经网络模型的一种AI芯片。需要较高的计算性能、能够处理海量的数据、具有一定的通用性, 芯片采购平台以便完成各种各样的学习任务,注重绝对的计算能力。

推断芯片:推断芯片主要是指利用训练出来的模型加载数据,计算“推理”出各种结论的一种AI芯片,注重综合指标,侧重考虑单位能耗算力、时延、成本等性能。

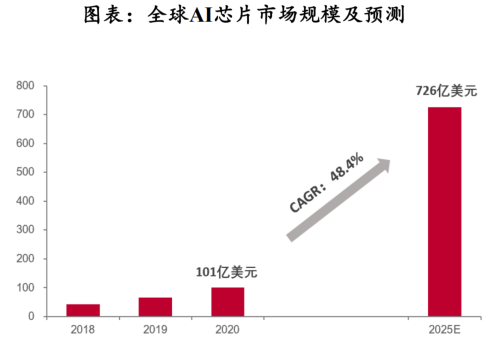

AI芯片是AI算力的核心,需求有望率先扩张。AI芯片是用于加速人工智能训练和推理任务的专用硬件,主要包括GPU、FPGA、ASIC等,具有高度并行性和能够实现低功耗高效计算的特点。

资料来源:IDC,中泰证券研究所

目前CPU+XPU异构形式成为AI服务器主流架构。传统的CPU单元对于AI计算任务的处理能力有限,而XPU(包括GPU、FPGA、ASIC等)则可以提供更强大的计算能力,因此将CPU和XPU结合起来使用可以实现计算任务的高效处理和资源的最优利用。一般来说,CPU负责整个系统的管理和控制,而加速芯片则负责AI计算任务的加速,两者相互协作,共同提升整个系统的性能。

服务器计算架构从单核的串行走向多核的并行,又进一步从同构并行走向异构并行,未来或将从异构并行走向超异构并行。目前在AI服务器中,常见的异构组合有8xGPU+2xCPU、4xGPU+2xCPU、8xFPGA+1xCPU、4xFPGA+1xCPU。在异构计算的趋势下,AI加速芯片搭载率将持续增高。根据IDC全球范围调研显示,2022年每台AI服务器上普遍多配置2个GPU,未来18个月GPU、ASIC、FPGA的搭载率均会上升。根据IDC数据,2021H1全球AI服务器市场规模达66.6亿美元,同比增长率超过全球AI整体市场增长率22.4%。预计在2025年全球AI服务器市场规模将达到277亿美元,CAGR(2020-2025)为20.3%。

2.2AI算力需求,存储芯片受益

ChatGPT带动AI服务器需求,存储芯片受益。ChatGPT的数据获取、数据整理、训练、推理除大算力芯片外,还需存储芯片支持。

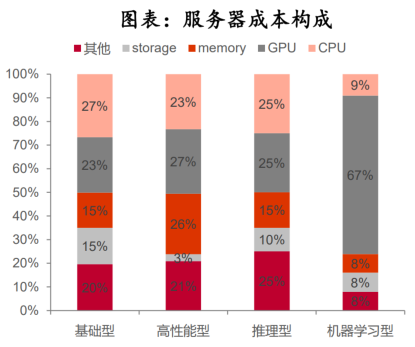

服务器成本构成:服务器成本包括算力芯片、存储器等,根据IDC 2018年服务器成本构成,在高性能服务器/推理型服务器/机器学习型服务器中存储占比29%/25%/16%。AI服务器,除了内存需要128GB或更大容量的高性能HBM和高容量服务器DRAM,还需硬盘去存储大量数据。

存储下游市场:智能手机+服务器+PC是主要下游。智能手机端出货量增速有限,单机容量提升是主要推动力;服务器端,受益人工智能、物联网和云计算等应用兴起,服务器出货量及单机容量提升推动增长。

资料来源:IDC、Dramexchange,SIA,中泰证券研究所

03.芯片需求增长拉动产业链机会

3.1 封测:Chiplet是AI芯片大势所趋

当前AI芯片呈现几大趋势:

1)制程越来越先进。从2017年英伟达发布Tesla V100 AI芯片的12nm制程开始,业界一直在推进先进制程在AI芯片上的应用。英伟达、英特尔、AMD一路将AI芯片制程从16nm推进至4/5nm。

2)Chiplet封装初露头角。2022年英伟达发布H100 AI芯片,其芯片主体为单芯片架构,但其GPU与HBM3存储芯片的连接,采用Chiplet封装。在此之前,英伟达凭借NVlink-C2C实现内部芯片之间的高速连接,且Nvlink芯片的连接标准可与Chiplet业界的统一标准Ucle共通。而AMD2023年发布的Instinct MI300是业界首次在AI芯片上采用更底层的Chiplet架构,实现CPU和GPU这类核心之间的连接。

3)2020年以来头部厂商加速在AI芯片的布局。AI芯片先行者是英伟达,其在2017年即发布Tesla V100芯片,此后2020以来英特尔、AMD纷纷跟进发布AI芯片,并在2022、2023年接连发布新款AI芯片,发布节奏明显加快。

据相关论文,芯片成本变化有以下规律:

1)封装形式越复杂,封装成本、封装缺陷成本占芯片成本比重越大:具体来说,SoC<MCM<InFO小于2.5D。

2)芯片面积越大,芯片缺陷成本、封装缺陷成本占比越大;

3)制程越先进,芯片缺陷成本占比越高,而Chiplet封装能有效降低芯片缺陷率,最终达到总成本低于SoC成本的效果。

制程越先进、芯片组面积越大、小芯片(Chips)数量越多,Chiplet封装较SoC单芯片封装,成本上越有优势:

Chiplet主要封装形式有MCM/InFO/2.5D这三种。14nm制程下,当芯片面积超过700mm²时,Chiplet封装中的MCM成本开始较SoC低,当面积达900mm²时,MCM较SoC成本低近10%(2颗chips)、或低20%(3颗chips)、或低25%(5颗chips);

7nm制程下,芯片面积超过400mm²时,MCM成本开始低于SoC,面积超过600mm²时,InFO成本开始低于SoC,当面积达900mm²时,5颗chips情况下,MCM较SoC成本低40%、InFO较SoC成本低20%;5nm制程下,芯片面积超过300mm²时,MCM成本开始低于SoC,成本超过500mm²时,InFO成本开始低于SoC,当面积达900mm²时,5颗chips情况下,MCM较SoC成本低50%、InFO较SoC成本低40%、2.5D较SoC成本低28%。

鉴于当前AI芯片朝高算力、高集成方向演进,制程越来越先进,Chiplet在更先进制程、更复杂集成中降本优势愈发明显,未来有望成为AI芯片封装的主要形式。

3.2 PCB:AI服务器基石

ChatGPT数据运算量增长快速,带动服务器/交换机/显卡等用量提升,布局相应领域PCB公司显著受益。ChatGPT带来了算力需求的激增,与之对应亦带来相应服务器/交换机等作为算力核心载体和传输的硬件,带来PCB需求大幅增长,同时随着对算力的要求越来越高,对于大容量、高速、高性能的云计算服务器的需求将不断增长,对PCB的设计要求也将不断升级,提升对于高层数、大尺寸、高速材料等的应用。

以23年发布的新服务器平台为例,Pcie5.0服务器用PCB层数、材料、设计工艺均有升级,PCB价格提升显著,其层数从4.0的12-16层升级至16-20层,根据Prismark的数据,2021年8-16层板的价格为456美元/平米,而18层以上板的价格为1538美元/平米,PCB价值量增幅明显;另外配套新服务器,交换机、传输网产品都需要同步升级,预计400G、800G交换机对PCB板子拉动巨大,进一步带动数通板景气度提升。

- Skyworks、Qorvo两家射频芯片巨头合并2025-10-30

- 恩智浦(NXP)25Q3 财报受益于汽车芯片2025-10-29

- 安世半导体(Nexperia)接连遭遇双重监管冲击,BOM表芯片缺货怎么办!2025-10-17

- 全球FPGA芯片市场布局2025-10-08

- 瑞芯微 RK3588 与即将量产的新旗舰芯片 RK3688 对比解析2025-09-29

- 国产芯片MCU极海推出APM32F035电机控制专用 MCU无电解电容变频控制方案2025-09-26